AI鉴GAY 我们真的想要生活在一个看脸的世界吗

人工智能的隐忧:科技日报记者张毅报道英国科学家网站近日报道

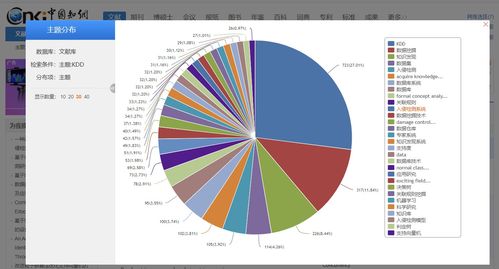

在提供购房和租房建议时,对黑人用户倾向于推荐低收入社区,这一行为被指存在种族偏见,引发了对美国历史上长期存在的租房歧视问题的关注。随着人工智能(AI)技术的不断发展,其潜在问题也日益凸显。大型模型频繁暴露出的偏见和歧视问题,正是这一问题的缩影。

人工智能技术的快速发展,其背后隐藏的问题也逐渐显现。例如,在房地产领域,AI系统在推荐房源时,可能会根据用户的种族背景进行不公平的推荐,这种行为被认为是一种隐形的偏见。这种偏见不仅反映了美国历史上长期存在的租房歧视问题,也暴露了AI技术在处理复杂社会问题时的局限性。

有性别偏见的AI结合国家妇女组织官网近日报告指出,美国加州大学哈斯商学院的一项研究分析了不同行业的个人系统。这项研究揭示了AI在不同行业中可能存在的性别偏见问题,进一步加剧了公众对AI技术公平性的担忧。

这些问题的出现,不仅挑战了AI技术的公正性,也对其发展提出了新的要求。AI技术的发展不应仅仅追求效率和智能,更应注重其对社会公平和正义的影响。科技界和政策制定者需要共同努力,确保AI技术的发展能够促进社会的整体福祉,而不是加剧社会的不平等。

人工智能技术的发展带来了巨大的机遇,但同时也伴随着挑战。如何确保AI技术的公平性和正义性,AI鉴GAY 我们真的想要生活在一个看脸的世界吗是当前科技发展中亟待解决的问题。通过不断的研究和改进,我们期待AI技术能够在促进社会进步和公平正义方面发挥更大的作用。

免责声明:本网站部分内容由用户自行上传,若侵犯了您的权益,请联系我们处理,谢谢!联系QQ:2760375052